Was ist die robots.txt Datei?

robots.txt: Was muss beachtet werden?

In manchen Fällen kann es aber von Bedeutung sein, den Webcrawlern (Robots) der Suchmaschinen den Zugang zu verwehren – etwa bei privat genutzten Seiten, sensiblen Login-Bereichen oder wenn sich eine Seite im Aufbau befindet. Und hier kommt robots.txt ins Spiel: Die Datei sagt Google und Co vor dem Betreten einer Webseite ganz genau, in welche Bereiche die Crawler hinein spitzeln dürfen und in welche nicht.

Robot Exclusion Standard

Die Datei robots.txt basiert auf dem sogenannten „Robots Exclusion Standard Protokoll“ von 1994: Darin wurde festgelegt, dass die Robots von Suchmaschinen wie beispielsweise Google, Yahoo und Bing sich nach den Anweisungen der Textdatei robots.txt richten müssen. Sprich: bevor Webseiten überhaupt erfasst werden dürfen, müssen die enthaltenen Vorgaben gelesen werden.

robots.txt in oberster Verzeichnisebene

Wichtig dabei: Der Dateiname muss in Kleinbuchstaben geschrieben werden! Eine Ausnahme bilden jedoch CMS-Systeme: beispielsweise WordPress erstellt eine eigene robots.txt Datei, die Crawlern den Zugriff auf alle Seiten erlaubt, jedoch manuell angepasst werden kann.

robots.txt erstellen

Zur Erstellung der robots.txt wird nicht sonderlich viel Equipment benötigt: Der klassische Texteditor reicht vollkommen, denn sie wird im Plaintext-Format als txt-Datei abgespeichert und ausgelesen. Umso wichtiger sind jedoch Rechtschreibung und Zeichensetzung: schon kleinste Fehler können dazu führen, dass die Befehle missachtet und Webseiten dennoch indexiert werden. Als Hilfe gibt es jedoch kostenfreie Tools zur Erstellung der robots.txt Datei: diese fragen die wichtigsten Informationen ab und erstellen die Datei automatisch.

Aufbau einer robots.txt

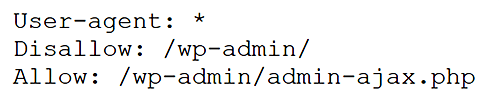

Anweisungen von robots.txt bestehen generell aus zwei Teilen: Im ersten Teil ist angegeben, für welche Robots (User Agents) eine Anweisung gilt, im darunter Teil befinden sich die jeweiligen Befehle. Der Aufbau jeder Anweisung ist gleich: Nach den Schlüsselworten „User-agent“ oder „Disallow“ folgt ein Doppelpunkt sowie ein Leerzeichen – und die jeweilige Angabe bzw. der Pfad. Verschiedene Anweisungsblöcke müssen darüber hinaus immer mit einer Leerzeile getrennt werden.

robots.txt: Beispiele

Die wichtigsten Kommandos

Die wichtigsten Bots bzw. User Agents

Bedeutung der robots.txt für SEO

Im Hinblick auf die Suchmaschinenoptimierung macht es durchaus Sinn, die Indexierung einer Webseite zu steuern. Auf diese Weise erscheinen irrelevante Seiten, Verzeichnisse und Inhalte nicht in den Suchmaschinen – stattdessen werden nur relevante Seiten sichtbar. Um also den Index „sauber“ zu halten, ist die robots.txt Datei ein willkommenes Werkzeug – sofern sie bis ins Detail durchdacht und fehlerfrei angelegt wurde. Denn haben sich auch nur kleinste Widersprüche eingeschlichen – wurden beispielsweise Verweise auf HTML Seiten gesetzt, die per robots.txt ausgeschlossen sind – dann kann das zu unklaren Suchergebnissen führen, die das Ranking einer Seite wiederum negativ beeinflussen können.

Achtung: robots.txt schützt nicht vor Zugriffen

Im Gegensatz zu Suchmaschinen ignorieren Webbrowser die robots.txt Datei. Das bedeutet: Mithilfe von robots.txt können zwar Suchmaschinen beeinflusst, nicht aber Dateien oder Verzeichnisse vor Zugriffen geschützt werden. Darüber hinaus sind auch nicht sämtliche Robots unbedingt verpflichtet, den Robot Exclusion Standard einzuhalten: Während sich die größeren Suchmaschinen wie Google, Bing oder Yahoo zwar danach richten, ist es nicht ausgeschlossen, dass gesperrte Seiten dennoch gecrawlt werden.

Sie haben eine Frage zum Thema Google Search-Snippets?

Sie möchten mit SEO mehr Klicks und Besucher auf Ihre Webseite holen? Unsere SEO-Agentur berät Sie gerne!